|

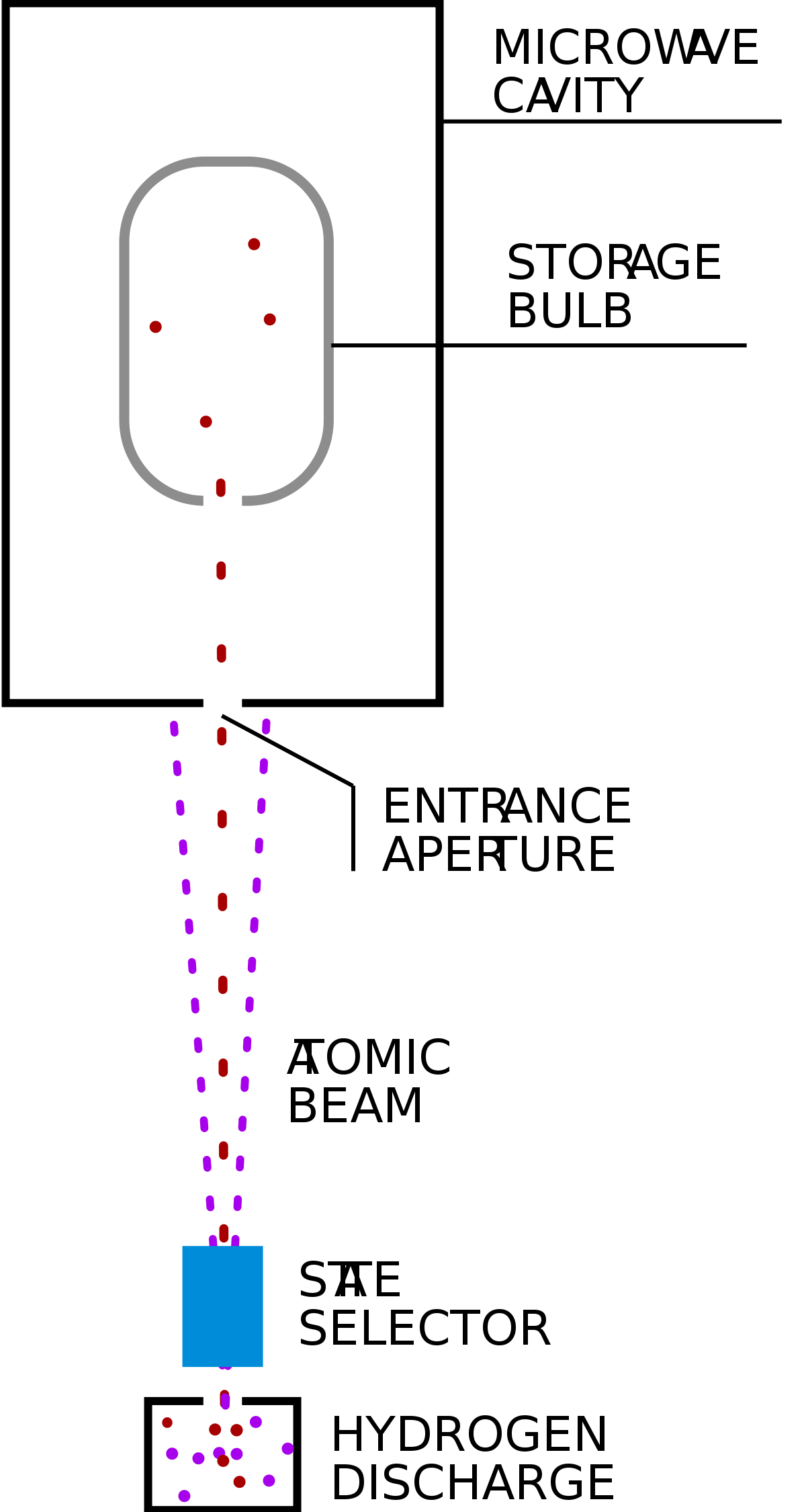

| Comparativa de los principales sistemas de posicionamiento (Fuente: GPS for Land Surveyors, CRC Press) |

Lee aquí los otros artículos de la serie Atrapar un Segundo.

En el anterior artículo de esta serie, nos encontramos con que los responsables de medir el tiempo a nivel internacional se ven obligados a incluir segundos "extra" (intercalares) en ciertos momentos para ajustar sus ultraprecisos relojes a la imperfecta rotación terrestre.

El ciudadano medio ni se da cuenta de que le han regalado un segundo en un año. Sin embargo, ciertos sistemas informáticos tienen que ser vigilados durante esas jornadas para que no se produzcan errores indeseados. Ya se han dado en el pasado varios problemas de este tipo y cada vez hay más voces pidiendo que se elimine esta práctica. Tengamos en cuenta que desde los años 70 más de la mitad de los años han tenido su segundo añadido, y el número de sistemas vulnerables cada vez es mayor.

Entre las soluciones adoptadas para evitar los segundos intercalares, está la que aplica Google en sus sistemas, que consiste en repartir ese segundo en pequeñas porciones (milisegundos) a lo largo de un periodo más o menos largo. Otra solución sería la opuesta, es decir, acumular retraso y luego añadir toda una hora cada 600 años aproximadamente.

Cualquier apaño, en todo caso, solo funcionará a escalas de unos pocos cientos de años, dado que la constante ralentización de la rotación de la Tierra nos llevaría dentro de 4000 años a tener que introducir ¡dos segundos extra cada mes! para mantener el estándar UTC (si con suerte queda alguien para contarlo).

La solución de acumular retraso es la que, aparentemente, es más práctica. Fue propuesta por la Unión Internacional de Telecomunicaciones, pero hasta hace muy poco no ha logrado un consenso entre todos los países. Aunque, ojo, solo podremos decir adiós a los odiosos segundos intercalares hasta 2035.

Los sistemas de posicionamiento, los grandes damnificados.

Antes que cualquier otro, el sistema de posicionamiento GPS tomó la drástica decisión. El sistema gestionado por la Fuerza Espacial norteamericana simplemente ignora estos segundos intercalares y ya lleva un buen puñado de segundos de diferencia respecto a UTC. La razón es que fue diseñado sin contar con esos saltos, que provocarían que en un instante los miles de millones de dispositivos GPS del mundo perdieran la medida y pasaran por un proceso de resincronización. Semejante apagón tendría un efecto que no podemos ni imaginar.

Otros sistemas de posicionamiento (Galileo y GLONASS) sin embargo, han adoptado sus propias soluciones a medida, distintas de GPS y que cuentan en mayor o menor medida con los segundos intercalares, complicando aún más las posibilidades de llegar a acuerdos entre países.

Finalmente, el 18 de noviembre de 2022, se logró el acuerdo entre los países reunidos en la BIPM (Oficina Internacional de Pesos y Medidas) para eliminar los segundos intercalares. El desacuerdo entre sistemas de posicionamiento, al que aludíamos antes, ha sido el principal escollo para que finalmente se haya tenido que dar un plazo tan largo para la adopción de esta medida, hasta 2035.

Pero... si solo es un segundito de nada.

Para comprender la importancia de este acuerdo, tenemos que darnos cuenta que, desde que se inventaron los leap seconds, a mediados del s. XX, los sistemas informáticos han evolucionado enormemente, se han hecho globales, extraordinariamente más rápidos y, por tanto, dependen cada vez más de una sincronización ultraprecisa. Sistemas financieros y bursátiles, telecomunicaciones, redes científicas, sistemas de alerta de desastres, y un largo etcétera requieren cada vez más de un flujo constante en la medida del tiempo.

Efectivamente, tan importante como la medida exacta de los segundos, es que su flujo sea constante. Si tenemos que dar "saltos" en el flujo de segundos (para añadirlos o, aún peor, para sustraerlos), cada sistema tiene que solucionar ese salto individualmente, generando un intervalo caótico de resincronización que no podemos permitirnos.

Podría ser peor: ¡segundos negativos!

Por si faltara algo más para enredar esta madeja gordiana (si se me permite la expresión), nuestro caprichoso planeta sigue con sus bamboleos, que ahora empiezan a ir en sentido contrario. Muy pronto podrían ser necesarios ¡segundos intercalares negativos!, o sea, suprimir segundos en lugar de añadirlos, como se había estado haciendo hasta ahora. Algo que no se ha hecho nunca y no se sabe muy bien cómo se podrá resolver.

El estándar UTC en peligro.

El retraso en paliar este problemón estaba amenazando la propia permanencia de UTC como estándar internacional. Diferentes países y organizaciones utilizan sus propios estándares de tiempo coordinado (el más prominente, el GPS estadounidense), y esta tendencia era cada vez mayor. Cada vez se veía más cercano el momento en que UTC pasara al olvido, con todas las consecuencias que podría desencadenar una ruptura semejante en el consenso del sistema de pesos y medidas internacional.

Para ponernos en contexto, tuvieron que pasar siglos hasta que todos los países llegaron a convencerse de que era buena idea eso de consensuar los pesos y medidas, que no valía eso de medir el "pie del rey" de turno. Que uno de esos consensos se pierda y la confianza en estos sistemas internacionales se resquebraje es la pesadilla de cualquier técnico o científico.

|

| Elisa Felicitas Arias (foto: UNAHUR) |

La argentina Felicitas Arias, exdirectora del Departamento de Tiempo de la Oficina Internacional de Pesos y Medidas, ha sido una de las figuras principales para la abolición de los segundos intercalares. En sus propias palabras: "Hay un problema que tenemos que parar, que es la proliferación de pseudoescalas de tiempo, que no son escalas en el sentido metrológico del término".

La política entra en escena

Es cierto que las razones técnicas han sido la principal razón que ha forzado, por fin, el acuerdo, y ha sentenciado a los molestos segundos intercalares para desaparecer dentro de poco más de una década. No olvidemos, sin embargo, que el problema amenazaba también con saltar a la arena política.

La ITU (Unión Internacional de Telecomunicaciones), dependiente de Naciones Unidas, ya estaba empezando a recomendar el uso de GPS como escala de tiempo, lo que hubiera dado al gobierno estadounidense un control sin precedentes sobre algo tan delicado. Ni que decir tiene que esto ha puesto muy nerviosa a Rusia y su GLONASS, precisamente en unos momentos de altísima tensión por la invasión de Ucrania.

Curiosamente, en la misma postura de Rusia, aunque por razones distintas, se ha posicionado el representante del Vaticano, el reverendo Pavel Gabor. El astrofísico y sacerdote, vicedirector del observatorio astronómico de este pequeño pero influyente estado, defendió que no se pierda la "antigua y sagrada" conexión con la rotación terrestre, las estrellas y el más allá, la cual nos ayuda a ver el tiempo como un "constante recordatorio de nuestra mortalidad".

|

| Rev. Pavel Gabor (Foto: Observatorio Vaticano) |

Aunque ahora su participación sea anecdótica, no olvidemos que históricamente la Iglesia ha sido uno de los motores en la medición del tiempo, y que fue un papa el que promovió en 1582 el calendario que hoy día usamos universalmente.

Por suerte, se ha podido aplacar a Rusia y demás reticentes incorporando un largo periodo de transición hasta 2035. Lo que pasará a medida que el desajuste entre el horario oficial y la rotación terrestre se vaya haciendo más y más grande, es cuestión que tendrán que dilucidar los científicos del futuro. Quizá se añada una hora dentro de 600 años, pero... eso será otra historia muy, muy lejana.

Referencias:

- UTC – The World's Time Standard, en timeanddate.com.

- Leap Second Table (AI Solutions)

- Time Has Run Out for the Leap Second (The New York Times)